ด้วยความที่ “Facebook” เป็นแพลตฟอร์ม Social Network ใหญ่สุดของโลก ที่มีฐานผู้ใช้งานมากกว่า 2,000 ล้านราย เมื่อมีคนจำนวนมหาศาลอยู่บนแพลตฟอร์มเดียวกัน และสามารถเชื่อมต่อถึงกันได้ทั่วโลก จำเป็นอย่างยิ่งต้องมีการกำหนดนโยบายมาตรฐานชุมชน (Community Standards) สำหรับผู้ใช้งาน Facebook ซึ่งเป็นกฎเกณฑ์ที่กำหนดว่าเนื้อหาใดสามารถ และไม่สามารถแบ่งปันบนแพลตฟอร์มได้

3 หลักการนโยบาย Facebook ตรวจเข้ม

“Facebook” เผยว่าเพื่อให้ผู้ใช้งานรู้สึกอิสระ และปลอดภัยในการแสดงตัวตนของพวกเขา จึงคำนึงถึงหลักการสำคัญ 3 ประการบนมาตรฐานชุมชน คือ

– ความปลอดภัย เพราะถ้าผู้ใช้ไม่รู้สึกถึงความปลอดภัยในการใช้ Facebook จะส่งผลให้คนเหล่านั้นเลิกใช้

– การแสดงความคิดเห็น เปิดโอกาสการแสดงความคิดเห็นอย่างเป็นอิสระที่สุดเท่าที่จะเป็นไปได้

– ความเป็นมาตรฐานเดียวกัน ต้องสามารถใช้นโยบายต่างๆ ของ Facebook ได้อย่างเท่าเทียม และสม่ำเสมอกับชุมชนที่มีอยู่ทั่วโลก ในทุกประเทศ และทุกวัฒนธรรม

“นโยบายมาตรฐานชุมชน มีการพัฒนา และเปลี่ยนแปลงทุก 2 อาทิตย์ ถ้ามีช่องว่าง หรือเจอว่านโยบายเราตรงส่วนไหนยังต้องปรับปรุง เราจะมีการเปลี่ยนแปลง เพื่อให้เหมาะสมกับบริบททางวัฒนธรรม สังคม และภาษา รวมถึงวิธีการที่ชุมชนทั่วโลกของเรากำลังใช้งานแพลตฟอร์มของ Facebook” คุณไซมอน ฮารารี ผู้จัดการฝ่ายนโยบายด้านเนื้อหาของ Facebook ประจำภูมิภาคเอเชีย ขยายความเพิ่มเติม

“พนักงาน 20,000 คน + AI” เบื้องหลังตรวจจับเนื้อหา

ทุกวินาที ในแต่ละวันมีโพสต์คอนเทนต์ ทั้งรูปแบบวิดีโอ – ภาพ – ข้อความมากมายบน Facebook ดังนั้นกระบวนการตรวจสอบเนื้อหาที่ถูกรายงาน (Report) เข้ามาจึงมีความสำคัญอย่างยิ่ง

เบื้องหลังการตรวจสอบเนื้อหาบน Facebook ประกอบด้วย 2 ส่วน คือ “พนักงาน” และระบบ “AI” (Artificial Intelligence)

ปัจจุบันได้เพิ่มพนักงานผู้ตรวจสอบเนื้อหาจาก 10,000 คน เป็น 20,000 คนในปีนี้ กระจายอยู่ทั่วโลก มีหน้าที่รับผิดชอบในการตรวจสอบเนื้อหาที่ถูกรายงานว่าเป็นการฝ่าฝืนกฎ โดยทีมงานเหล่านี้ทำงานครอบคลุมทุกเขตเวลา ตลอด 24 ชั่วโมง 7 วัน และรองรับได้มากกว่า 50 ภาษา รวมถึงภาษาไทย

ขณะเดียวกันลงทุน “AI” เพื่อทำให้สามารถตรวจจับเนื้อหาที่ฝ่าฝืนกฎในแบบเชิงรุก ซึ่งจะมาช่วยเสริมรายงานที่ทาง Facebook ได้รับเข้ามา

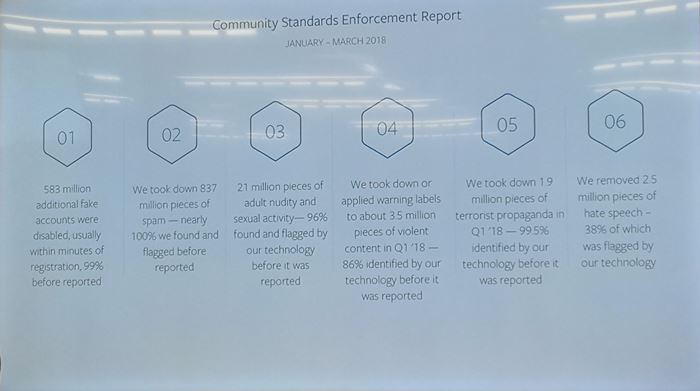

สำหรับสถิติการตรวจจับเนื้อหา และเอาออกจากแพลตฟอร์ม Facebook (ในช่วงระหว่างเดือนมกราคม – มีนาคม 2018)

– เอาบัญชีปลอม (Fake Accounts) ออก จำนวน 583 ล้านบัญชี โดยในจำนวนนี้ 99% ทาง Facebook ตรวจเจอ และเอาออกก่อนที่จะมีผู้ใช้รายงานเข้ามา

– เอาสแปมออกไป 837 ล้านสแปม โดยเกือบ 100% ทาง Facebook ตรวจเจอ และเอาออกก่อนที่จะมีผู้ใช้รายงานเข้ามา

– เอาเนื้อหาโป๊เปลือย และเกี่ยวกับทางเพศออกไป 21 ล้านเนื้อหาออกจาก Facebook โดย 96% ของเนื้อหามาจาก “AI” ตรวจเจอ ก่อนที่จะมีผู้ใช้รายงานเข้ามา

– เอาเนื้อหารุนแรง 3.5 ล้านเนื้อหาออกจาก Facebook โดย 86% ของเนื้อหามาจาก “AI” ตรวจเจอ

– เอาเนื้อหาโฆษณาชวนเชื่อของผู้ก่อการร้าย 1.9 ล้านเนื้อหาออกจาก Facebook โดย 99.5% มาจาก AI ตรวจเจอ

– เอาเนื้อหาที่ใช้วาจาสร้างความเกลียดชัง 2.5 ล้านเนื้อหาออกจาก Facebook

6 ประเภทเนื้อหาขัดต่อนโยบาย

ในขณะที่ Social Network ทำให้คนทั่วโลกเชื่อมต่อถึงกันได้อย่างง่ายดาย และเข้าถึงข้อมูลข่าวสารได้ทั่วทุกมุมโลก รวมถึงเป็นช่องทางสร้างรายได้ให้กับธุรกิจต่างๆ แต่อีกมุมหนึ่งเปรียบเป็นเหรียญสองด้าน เพราะมีผู้ใช้งานบางส่วน ใช้สื่อสังคมออนไลน์ในทางที่ผิด ดังนั้น ปีนี้ “Facebook” เผยแพร่รายงานเนื้อหา 6 ประเภทที่จะถูกลบออกจากแพลตฟอร์ม ซึ่งเป็นเนื้อหาที่ฝ่าฝืนกฎนโยบาย ได้แก่

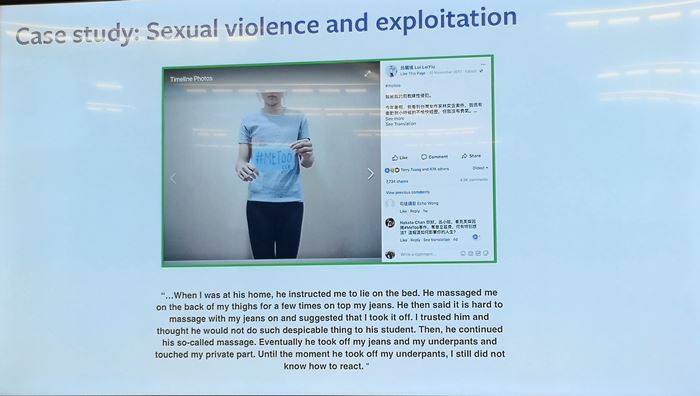

– เนื้อหาโป๊เปลือย และกิจกรรมทางเพศ (nudity & sexual activity)

– เนื้อหาความรุนแรง (content violence)

– โฆษณาชวนเชื่อของผู้ก่อการร้าย (terrorist propaganda)

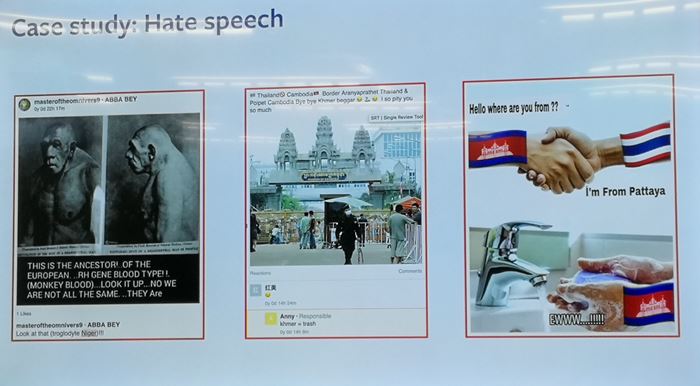

– เนื้อหาที่ใช้วาจาสร้างความเกลียดชัง (hate speech)

– บัญชีผู้ใช้ปลอม (fake accounts)

– สแปม (spam)

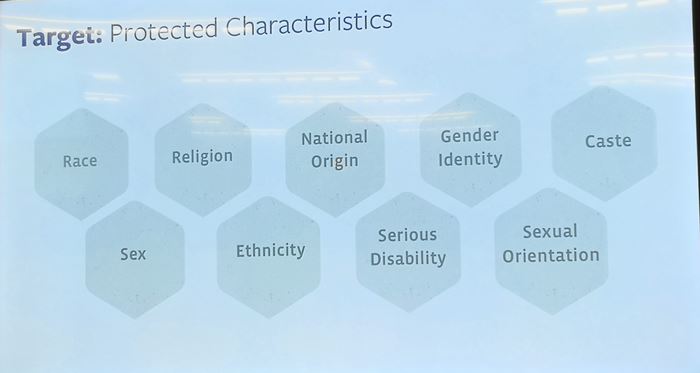

ทั้งนี้ เนื้อหาที่ใช้วาจาสร้างความเกลียดชัง เช่น เกี่ยวข้องกับชาติพันธ์, ถิ่นกำเนิด, ชนชั้นวรรณะ, อัตลักษณ์ทางเพศ (ความรู้สึกว่าตัวเองบ่งบอกว่าเป็นเพศไหน)

อย่างไรก็ตามในกรณีผู้ที่ถูกรายงาน หรือผู้ที่ถูกลบเนื้อหาออก สามารถยื่นคำร้องต่อการตัดสินของ Facebook ได้เช่นกัน ใน 4 ประเภทเนื้อหา คือ ภาพโป๊เปลือย, กิจกรรมทางเพศ, การใช้วาจาสร้างความเกลียดชัง และเนื้อหาของผู้ก่อการร้าย

เพิ่มมาตรการความปลอดภัย “กลุ่มผู้ใช้วัยรุ่น”

นอกจาก 6 ประเภทเนื้อหาแล้ว ในเชิงของกลุ่มผู้ใช้งาน ทาง Facebook มีนโยบายสำหรับผู้ใช้งาน กลุ่มอายุ 13 – 18 ปีโดยเฉพาะ โดยเนื้อหาที่ปรากฏอยู่บน Feed ของบัญชีผู้ใช้งานอายุ 13 – 18 ปี จะแตกต่างจากกลุ่มผู้ใหญ่ โดยจะถูกคัดกรอง และในกรณีที่ใครรู้สึกถูก Bully เช่น คอมเมนต์ หรือโพสต์ภาพเชิงถูกกลั่นแกล้ง ผู้ที่โดนกระทำ สามารถรายงานเข้ามายัง Facebook

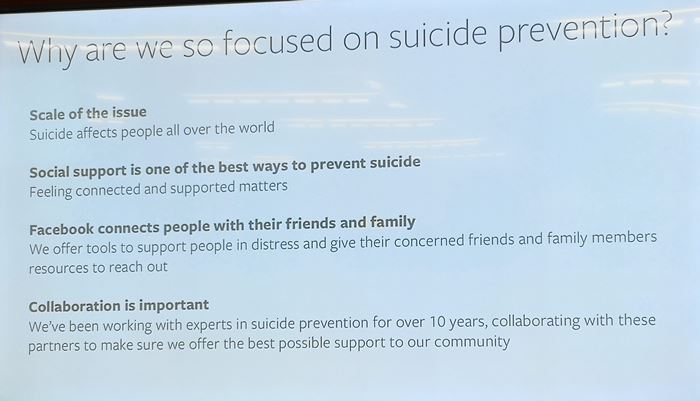

คุมเข้ม “Live Video – Post ฆ่าตัวตาย”

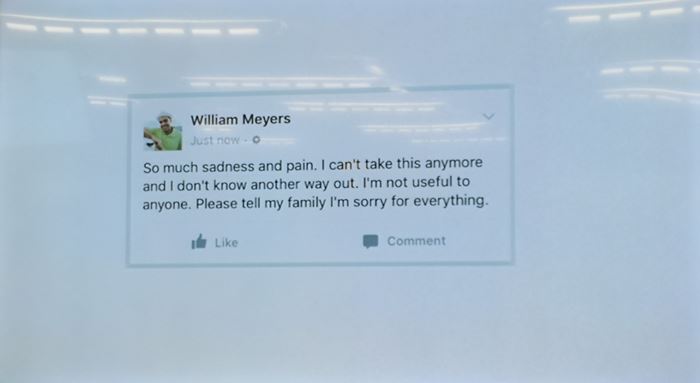

อีกหนึ่งประเด็นที่เป็นกระแสสังคม คือ มีผู้ใช้งาน Facebook ใช้โปรแกรม Live ถ่ายทอดสด “ฆ่าตัวตาย” รวมถึงโพสต์เนื้อหาที่สุ่มเสี่ยงต่อการฆ่าตัวตายในอนาคต

ด้วยเหตุนี้ “Facebook” จึงออกนโยบายความปลอดภัยการใช้ Live และ Post ต่อกรณีดังกล่าว เพื่อให้ความช่วยเหลือผู้ที่กำลังคิดจะฆ่าตัวตาย

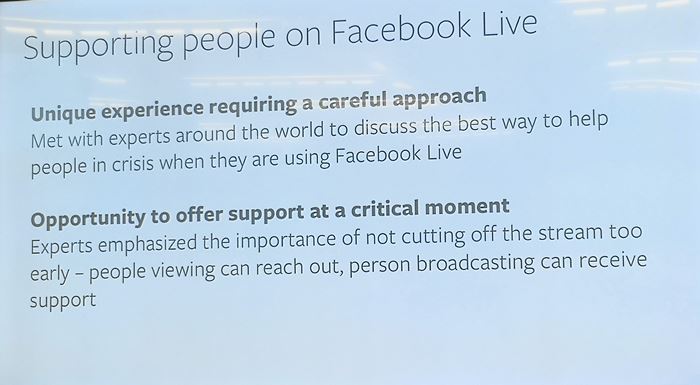

สำหรับกรณี Live Video ฆ่าตัวตาย หากมีปรากฏขึ้นมา ทาง Facebook ให้ข้อมูลว่าจะไม่เอาเนื้อหานั้นออกทันที เนื่องจากผู้เชี่ยวชาญด้านจิตวิทยาให้คำแนะนำว่า

1. การไม่เอา Video Live ฆ่าตัวตายลงทันที เพราะทำให้ทีมงาน Facebook เห็นความเคลื่อนไหวของคนๆ นั้น และให้ความช่วยเหลือได้

2. ถ้าเอา Video Live ลงทันที จะทำให้เจ้าของวิดีโอที่กำลังจะฆ่าตัวตาย รู้สึกเดี่ยวดาย จะยิ่งเร่งให้คนๆ นั้นลงมือกระทำการเร็วขึ้น

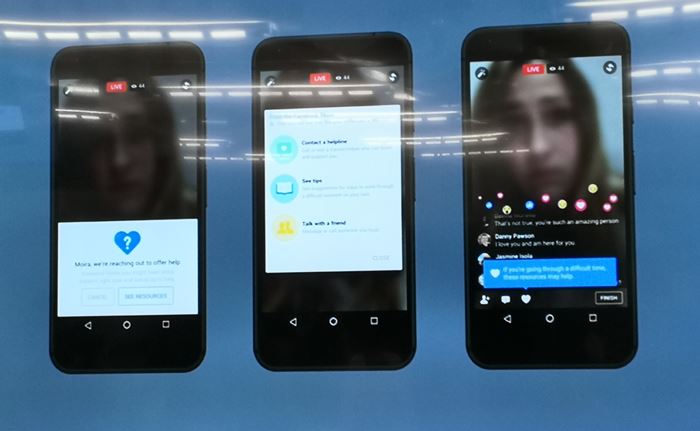

ขณะเดียวกันในระหว่างที่คนๆ นั้น Live อยู่ จะมีข้อความแจ้งเตือนขึ้นมา เช่น อยากคุยกับเพื่อนไหม หรืออยากคุยกับนักจิตวิทยาไหม หรือแสดงสถานะว่าขณะนี้มีคนเป็นห่วงคุณ

และในกรณีที่คนๆ นั้นตกอยู่ในอันตรายจริงๆ จะมีทีมพิเศษของ Facebook เร่งประสานงานกับเจ้าหน้าที่องค์กรที่ให้ความช่วยเหลือคนที่อยู่ในภาวะเครียด หรือซึมเศร้า ที่ทาง Facebook เป็นพาร์ทเนอร์ด้วย

โดยหลังจากสถานการรณ์คลี่คลายแล้ว ทาง Facebook จะถอนวิดีโอนั้นออกจากแพลตฟอร์ม

ส่วนกรณีโพสต์ข้อความที่สุ่มเสี่ยงต่อการจะฆ่าตัวตายในอนาคต เพื่อนของผู้ใช้งานคนนั้นๆ สามารถรายงานเข้ามายัง Facebook ขณะเดียวกันมีระบบ “AI” ตรวจเจอ ทาง Facebook ให้มีข้อแนะนำเทคนิคการพูดคุยกับคนที่กำลังอยู่ในภาวะเครียด และเสี่ยงจะฆ่าตัวตาย ส่งกลับไปยังเพื่อนของคนๆ นั้น